Americká nezisková společnost OpenAI před několika dny na svém blogu zveřejnila článek, ve kterém píše o tom, že vyvinula nový jazykový model, který je tak dobrý, že raději nezveřejní ani natrénovaný model, ani zdrojové kódy. Pro řadu médií (včetně některých seriózních českých) takové zprávy fungují jako červený hadr na býka a okamžitě tak začaly vznikat články o tom, že byla vyvinutá průlomová umělá inteligence, která je tak nebezpečná, že se musí držet pod pokličkou. Rád bych uvedl věci na pravou míru.

V první řadě je třeba přiznat, že OpenAI se v článku nedopustila žádného faulu a důvody, kvůli kterým nechtějí zveřejnit zdrojové kódy, znějí rozumně. Je však evidentní, že autoři dobře tušili, jak budou média reagovat a jde tak z jejich strany o promyšlený marketingový tah. O tom svědčí i poslední věta článku, která končí slovy „we’re hiring“.

A s čím tedy vědci z OpenAI přišli? Byl vytvořen zřejmě velmi dobrý jazykový model. Jazykovým modelem se rozumí nástroj, který na základě libovolné posloupnosti slov umí určit pravděpodobnosti možných slov, která by mohla následovat. Pro příklad uveďme posloupnost dvou slov

máma mele

Úkolem jazykového modelu je doplnit následující slovo posloupnosti. To může být teoreticky jakékoliv slovo, ale jistě každý tuší, že některá slova budou pravděpodobnější než jiná. Pravděpodobnosti následujících slov mohou vypadat například následovně:

slovo | pravděpodobnost |

|---|---|

| maso | 0,6 |

| kávu | 0,1 |

| koření | 0,1 |

| Emu | 0,01 |

| Ostatní slova | 0,19 |

Pokud díky jazykovému modelu známe pravděpodobnosti následujících slov, můžeme je vyžít pro generování úplně nových textů. Postup je následující:

- První slovo zvolíme sami, nebo ho vybere nějakým náhodným způsobem.

- Pravděpodobnosti pro následující slovo nám už určuje jazykový model. Slovo tedy vybereme náhodně s ohledem na tyto pravděpodobnosti. Je možné si to představit tak, že vezmeme hrací kostku, která nemá 6 stěn, ale tolik stěn, kolik různých slov máme k dispozici. Na každou stěnu takové kostky vlepíme závaží, jehož hmotnost bude odpovídat pravděpodobnosti daného slova.

- Onou hrací kostkou si hodíme a zapíšeme si slovo, které nám padlo. Tím nám vznikne posloupnost o jedno slovo delší. Na jejím základě podle jazykového modelu upravíme pravděpodobnosti pro následující slovo a celý postup opakujeme od bodu 2.

Klíčem k úspěchu a k vytvoření smysluplné posloupnosti slov je tedy kvalitní jazykový model. Na to existují už lety prověřené postupy. Nejprve potřebujeme dostatečně velkou kolekci textových souborů, která slouží jako vzorové texty. V oboru strojového učení se takovému datovému souboru říká trénovací data. Pokud se v těchto trénovacích datech bude po slovech máma mele vyskytovat maso častěji, než jiná slova, budeme chtít, aby jazykový model posloupnosti máma mele maso přiřadil velkou pravděpodobnost.

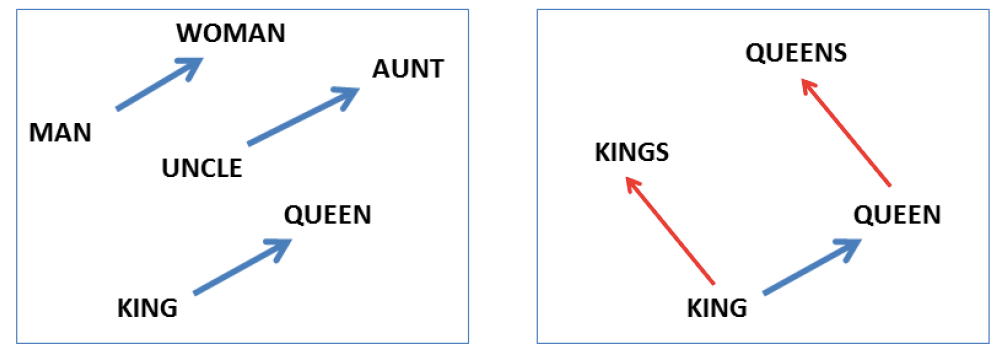

Na druhou stranu ale nechceme, ale si jazykový model jen zapamatoval časté posloupnosti. Chceme, aby byl schopný zobecňovat i na posloupnosti, které se v trénovacích datech nevyskytly. K tomu slouží algoritmy strojového učení.

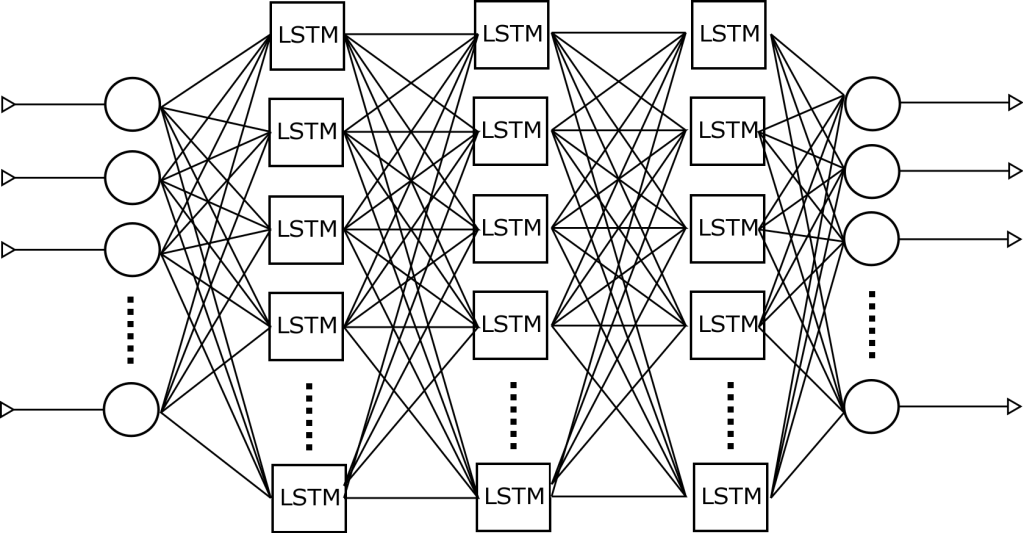

Podle článku OpenAI byly pro strojové učení použity „staré známé“ algoritmy (velmi podobné například tomu, který byl sloužit pro generování básní), jen trénovací data a kapacita paměti modelu byla o mnoho řádů větší než dříve. To bylo umožněno díky velmi výkonné výpočetní infrastruktuře, která běžným smrtelníkům mimo špičková AI centra není dostupná.

V čem tedy spočívá nebezpečí takového modelu? V žádném případě se nejedná o nějakou formu samostatně uvažující umělé inteligence. Stále jsou to jen náhodné procesy a statistiky počítané z trénovacích dat. Díky jejich složitosti je však možné generovat texty, které jsou velice podobné textům psaným lidmi. Zneužít je lze například pro strojové generování fake news nebo komentářů v diskuzích. S pomocí těchto přístupů je možné vygenerovat libovolné množství různorodého textu, které nebude stát víc než trochu elektrické energie.

Přitom texty nemusí být jen bezduchým blábolením. Zaměření textů je vždy dáno trénovacími daty. Pokud se pro trénování použijí ideově zabarvené propagandistické texty, výsledek bude k nerozeznání od lidmi psaného obsahu na některých fake news serverech.

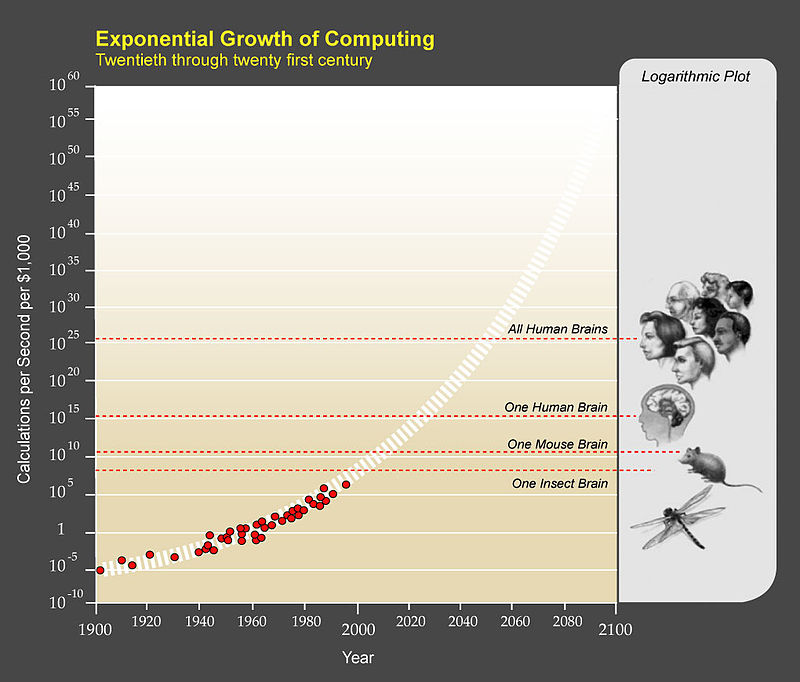

Sami autoři článku píší, že replikace jejich výsledků nebude velký problém. Přestože byly zveřejněny pouze zdrojové kódy menšího modelu, použité principy jsou ve vědecké komunitě dobře známy a jeho rozšíření je pro znalého člověka snadné. Jediným zásadním omezením je obrovská výpočetní náročnost. Ta se však týká jen procesu vytváření modelu. Jakmile model někdo vytvoří a zveřejní, jeho použití už je velmi snadné i s využitím řádově menšího výpočetního výkonu. Navíc z Moorova zákona víme, že výpočetní výkon počítačů roste v čase přibližně exponenciálně a nebude tedy trvat dlouho, než si takový generátor bude moci každý z nás natrénovat na svém mobilu.

Ze strany OpenAI tedy o žádný velký průlom nejde. Navíc by bylo naivní si myslet, že už se takovýmito generovanými texty náš mediální prosto dávno neplní. Jen se tím autoři těchto generátorů textů veřejně nechlubí.